独り火に向かい、その暖かさと燻煙、薪の爆ぜる音を五官で感じる時、人は煩瑣な日常から解放される。炎を見つめながら物思い、物憂う中、人は誰もが哲学者となる。本連載は、そんな孤独な炎を共有し、誌上で語り合わんとする試みである。

2種のコンピューター

哲学からは逸れるような気もしますが、最新のコンピューターサイエンスも、前回ご紹介した「アテナイの学堂」の延長線上にあります。最近話題となっているAI──Open AIの「Chat GPT」やGoogleの「Bard」などです。「我々の仕事が奪われるのか?」はたまた「心を持つようになり人類に反逆するのか」など、その未来をひたすらに心配する一方で、その仕組み、原理については知らない人って多いような気がします。

僕の場合は、5年前にNHKでやっていた東大、松尾豊教授の番組で聞き齧って、知ったかぶっていますから大丈夫です。えっへん。シーズン1とシーズン2の全24回を制覇しましたから、知ったかぶって皆さんにお伝えできます。超文系人間なので、基礎の基礎的な知識にとどまりますが──。

実はコンピューターには2種類あります。今話題の人工知能と、ひと昔前の「ノイマン型コンピューター」とは、そもそもの仕組みが違います。僕たちがふつう手にしているデバイスは、安い電卓にしても、パソコンにしても、ゲーム機やスマホにしても、基本的にはアラン・チューリングからジョン・フォン・ノイマンを経て開発された演繹的な演算で動いています。’97にチェスで、’13年に将棋で人間を打ち負かしたコンピューターもノイマン型でした。

一方、今話題になっている人工知能は「ディープラーニング」とか「深層強化学習型」などと呼ばれます。人の脳の神経細胞を模した回路(ニューラルネットワーク)を作り、帰納的な方法で答えを導き出します。古くは’58年のローゼンブラットによる発案から概念自体は存在していたそうですが、’06年にヒントンによる開発が始まり、 ’16年には難しいとされていた囲碁で人を破るようになりました。自動運転などの分野でも俄然注目を集め、その応用が一気に加速しています。

ノイマン型コンピューター

こちらは従来型となりますので、説明は不要かもしれませんが、次の「ディープラーニング型」との比較のために一応お話しておきましょう。極めて簡単に言えば、「入力」された数値を、「命令(プログラム)」通りに処理し、画面や音声で「出力」する──だけの装置、「演繹法」に基づいた演算をしています。

「演繹法」というのは「A=B」の時「B=C」とするならば、「A=C」が成り立つという三段論法に代表されるような証明法のことです。「大前提」と「小前提」から「結論」が導かれ、例えば、大前提「人は=死ぬ」、小前提「信長は=人である」が成り立つならば、「信長は=死ぬ」だろうという結論が類推されます。

前提(上)から結論(下)へと情報が流れていく訳ですが、コンピューターはそれを3段どころではなく、何千段も何万段も一瞬にしてやってのけるので、複雑な計算だけでなく、ゲームや映像などの処理も可能になるのです。

ディープラーニング型AI

一方こちらは「帰納法」。観測(下)から結論(上)へという逆の流れになります。「信長が=死んだ」「秀吉が=死んだ」「信玄が=死んだ」「謙信が=死んだ」「光秀が=死んだ」という事実を重ねることによって、「人は=死ぬ」と類推します。

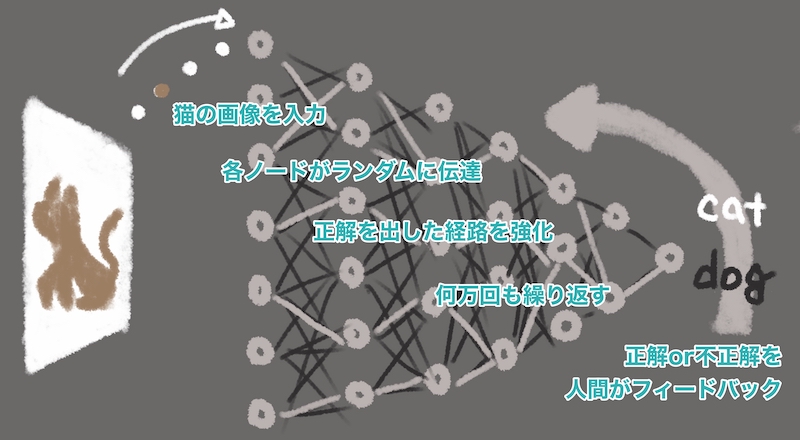

この場合は、何かのプログラムやアプリをコンピューターに走らせたりはしません。人間の脳細胞(ニューロン)が神経繊維(シナプス)でつながっているように、たくさんのノードをネットワーク状に繋げて、層を重ねて行きます。文章では伝わりにくいので、また絵に描いて説明します(’12年に世界の注目を集めた猫の画像認識の例)。

まず、一列目のノードに画素(ピクセル)を読み込ませていきます。一つ一つのピクセルは茶色だったり、薄茶色だったりする点の連続にすぎません。それだけで猫かどうかを判断することは、人間にも不可能です。そこで一列目のノードは、その情報が「猫っぽかった」or「猫っぽくなかった」をデタラメ(乱数で)に判断して2列目のノードに伝えます。そして2列目以降のノードもデタラメに判断して、次の層へと伝えて行きます。3列目、4列目、5列目と──。

最終的にAIは、その画像が「猫であるか否か」を判断します。判断と言ってもデタラメな何本もの道筋を、何層も渡り歩いてはじき出したデタラメな解答です。そして、もしその答えが間違っていたら、その時にたどったルートに負荷をかけ、次回からはそのルートをたどりにくくさせるのです。この行程を何回も繰り返していくうちに、そのネットワークは、猫っぽいピクセル列の特徴を、量的に学習していくのです。

演繹法と帰納法

画像認識の正答率を上げるためには何万枚、何千万枚もの写真を読み込ませないといけません。これは薬の治験などに似た作業です。何千人、何万人もの人に臨床試験をして、薬効を確かめます。10人ほどの人が治っても、薬が効いたという証明には不十分。何万人にも効いたとなれば、その理由は分からなくても薬効は証明されます。同様に、ディープラーニングのAIも、その識別に根拠や理由はありません。

逆に、画像認識はノイマン型コンピューターが苦手とする分野です。耳が2つあれば=猫。ヒゲがあれば=猫。茶色ければ=猫──などと演繹的に判断することが困難だからです。猫には様々な色があったり、横を向いていたり、後ろを向いていたり、様々な写真があるからです。それどころか、猫と背景を識別ことすら困難です。

「演繹法」と「帰納法」、それぞれに長所と短所があります。しかし我々の文明・科学は、その両者の証明法を相互に補完し合って発展してきました。そしてその方向性を遥か昔、ギリシャ時代に指し示したのがプラトンとアリストテレスだったと言われたら驚きませんか? 実に2000年以上に渡る射程距離です。